Reinforcement Learning in der Lieferkette: KI-optimierte Bestände

Yulia Fedorova

06 Mar 2025

Lieferketten sind ständig in Bewegung – Produkte wandern über Kontinente, die Nachfrage schwankt unvorhersehbar, und unerwartete Störungen können sich durch das gesamte Netzwerk ausbreiten. Dennoch verlassen sich viele Unternehmen weiterhin auf statische Prognosemodelle und starre Wiederbeschaffungsregeln, die mit dieser Komplexität kaum Schritt halten können.

Was wäre, wenn Lieferkettenentscheidungen sich in Echtzeit anpassen, aus vergangenen Ergebnissen lernen und sich kontinuierlich verbessern? Genau das bietet Reinforcement Learning (RL) für die Bestandsoptimierung in der Lieferkette.

Im Gegensatz zu traditionellen mathematischen Modellen, die auf vordefinierten Annahmen basieren, nutzt RL einen trial-and-error-Ansatz, um Lieferkettenprozesse dynamisch zu optimieren. Von Bestandsmanagement und Auftragsabwicklung bis hin zu Wiederbeschaffungsstrategien treffen RL-gestützte Algorithmen adaptive Entscheidungen, die sich an veränderte Bedingungen anpassen – und so Effizienz und Resilienz steigern.

In diesem Artikel zeigen wir, wie Reinforcement Learning die Bestandsoptimierung in der Lieferkette revolutioniert, warum es herkömmliche Wiederbeschaffungsmodelle übertrifft und wie numi RL erfolgreich in Software integriert hat, um bessere Entscheidungen zu ermöglichen.

Was ist Reinforcement Learning?

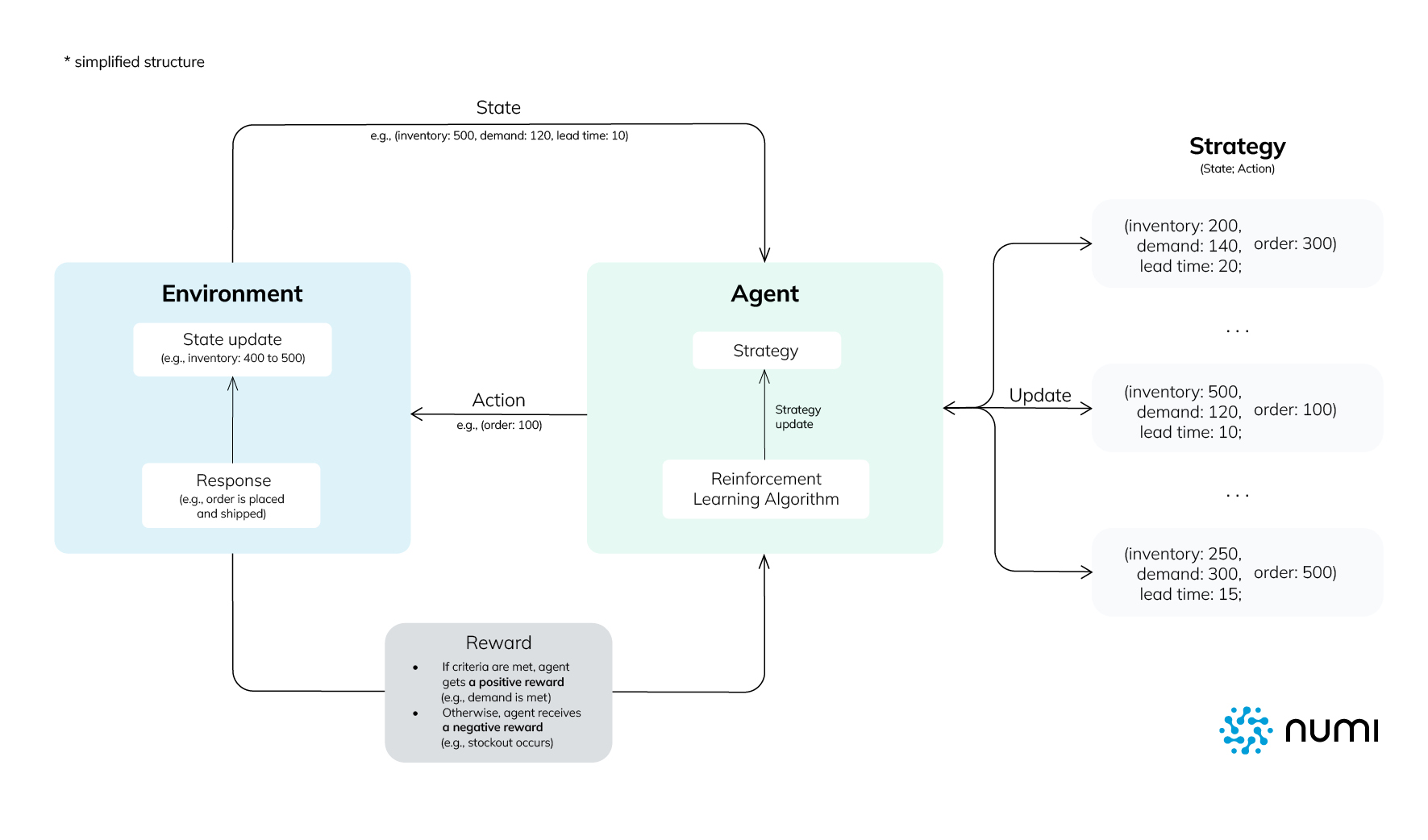

Reinforcement Learning ist ein Bereich des Machine Learning, der sich auf die Entscheidungsfindung in dynamischen Umgebungen konzentriert. Im Gegensatz zum traditionellen Supervised Learning, das auf gelabelten Daten basiert, nutzt RL einen Agenten, der mit seiner Umgebung interagiert, aus Feedback lernt und seine Handlungen im Laufe der Zeit optimiert, um langfristige Belohnungen zu maximieren.

Zentrale Komponenten des Reinforcement Learning

- Agent – Der Entscheidungsträger (z. B. ein Bestandsagent, der Lagerbestände verwaltet).

- Environment – Das System, in dem der Agent agiert (z. B. ein Lieferkettennetzwerk).

- Actions – Die Handlungsoptionen des Agenten (z. B. wie viel Bestand nachbestellt wird).

- Rewards – Das Feedback, das den Agenten leitet (z. B. Kosten minimieren und gleichzeitig Lieferengpässe vermeiden).

Im Kern folgt RL einem Trial-and-Error-Ansatz: Der Agent führt eine Aktion aus, beobachtet das Ergebnis und passt seine zukünftigen Entscheidungen entsprechend an. Im Laufe der Zeit verfeinert der Algorithmus seine Strategie, um die Leistung zu optimieren.

Wie sich Reinforcement Learning von traditionellem Machine Learning unterscheidet

- Kein Bedarf an gekennzeichneten Daten: RL lernt durch Interaktion mit dem System, anstatt sich auf historische Datensätze zu stützen.

- Adaptive Entscheidungsfindung: Im Gegensatz zu regelbasierten Systemen passt sich RL dynamisch an neue Situationen an.

- Langfristige Optimierung: RL berücksichtigt zukünftige Auswirkungen und nicht nur unmittelbare Gewinne.

Für Lieferketten machen diese Fähigkeiten RL besonders effektiv im Umgang mit Unsicherheiten, der Optimierung der Logistik und der Automatisierung komplexer Entscheidungen – Bereiche, in denen traditionelle Modelle oft an ihre Grenzen stoßen.

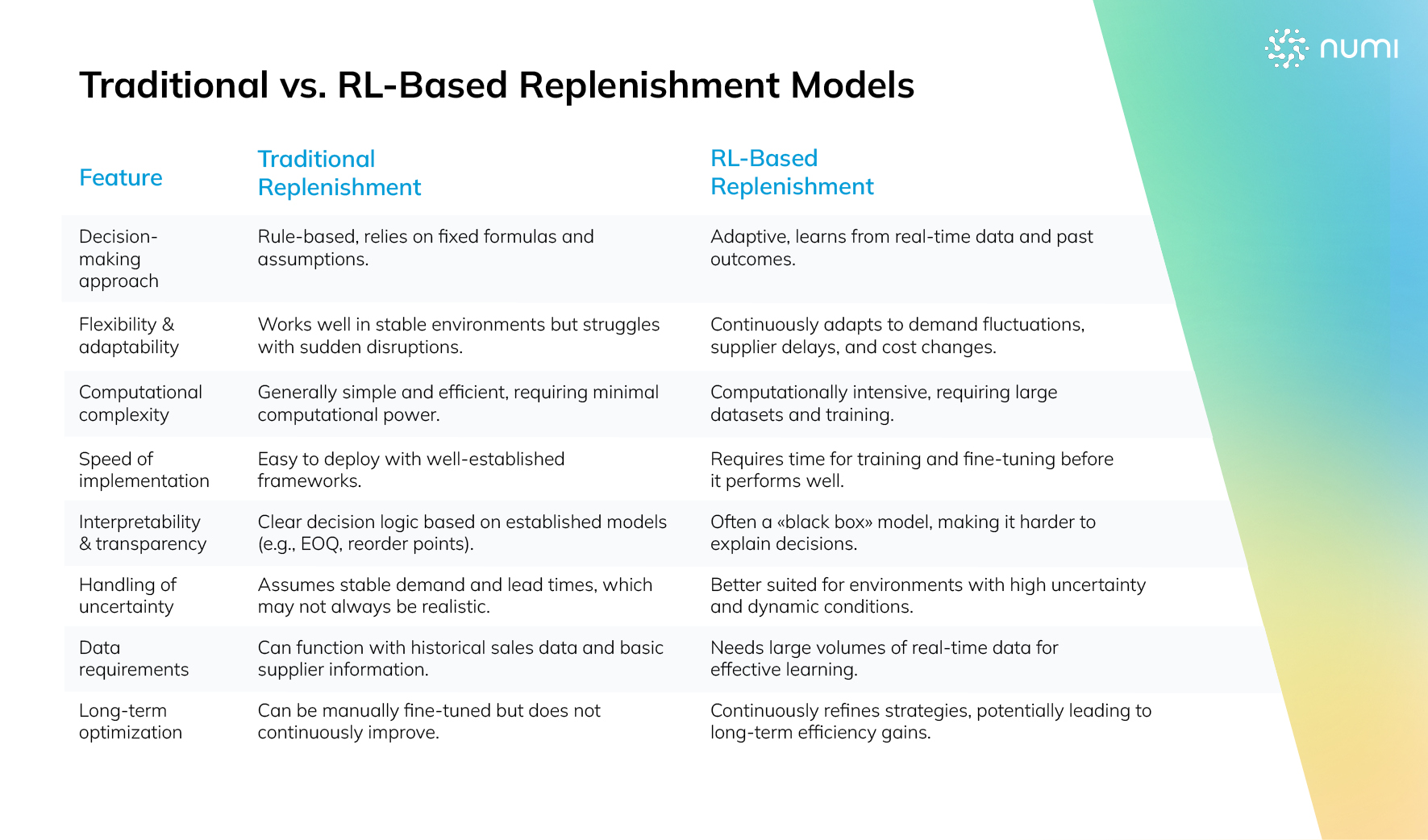

Lieferketten-Algorithmen im Reinforcement Learning

Das traditionelle Supply Chain Management stützt sich auf regelbasierte Systeme, statistische Modelle und mathematische Optimierungstechniken, um Bestände, Transporte und die Auftragsabwicklung zu steuern. Ansätze wie das Economic Order Quantity (EOQ)-Modell, Nachbestellpunkt-Strategien und lineare Programmierung funktionieren gut in vorhersehbaren Umgebungen, in denen die Nachfrage stabil ist, die Lieferanten zuverlässig sind und es nur wenige Störungen gibt.

In der Realität sind Lieferketten jedoch selten stabil. Schwankende Nachfrage, Lieferverzögerungen, steigende Kosten und unerwartete Störungen können starre Modelle schnell ineffizient machen. Reinforcement Learning bietet einen adaptiveren Ansatz, indem es kontinuierlich aus Echtzeitdaten lernt. Dadurch können Systeme ihre Entscheidungen dynamisch optimieren, anstatt sich auf feste Formeln zu verlassen.

Allerdings ist RL keine universelle Lösung. Während es in komplexen, unsicheren Umgebungen besonders leistungsfähig ist, ist es nicht immer die beste Wahl für hochstrukturierte Probleme mit klaren Einschränkungen – dort bleiben traditionelle Optimierungsmethoden oft interpretierbarer, vorhersehbarer und recheneffizienter. Entscheidend ist daher, zu verstehen, wann und wo RL einen echten Vorteil gegenüber herkömmlichen Modellen bietet.

Zentrale Anwendungen von Reinforcement Learning in der Lieferkette

1. Bestandsoptimierung

- RL-Agenten, oft als Bestandsagenten implementiert, lernen, Lagerbestände auszubalancieren, indem sie Nachfrageschwankungen vorhersagen und Bestellmengen dynamisch anpassen.

- Im Gegensatz zu traditionellen Modellen berücksichtigt RL Lieferantenzuverlässigkeit, Lieferzeiten und Saisonalität – ohne feste Annahmen vorab zu definieren.

2. Auftragsabwicklung & Lieferantenauswahl

- RL optimiert die Auswahl von Lieferanten und Lagern basierend auf Echtzeitbedingungen (Kosten, Standort, Verfügbarkeit).

- Bei Störungen kann RL Bestellungen dynamisch zu zuverlässigeren Lieferanten umleiten.

3. Transport- & Logistikplanung

- RL-basierte Routing-Algorithmen optimieren kontinuierlich Lieferpläne, minimieren Kraftstoffkosten, Verzögerungen und Ineffizienzen.

- Dies übertrifft statische Routing-Modelle, die sich nicht in Echtzeit an Wetter, Verkehr oder Lieferkettenstörungen anpassen können.

4. Produktionsplanung

- RL ermöglicht es Produktionsanlagen, Fertigungspläne flexibel an unerwartete Maschinenausfälle oder Materialengpässe anzupassen.

- Traditionelle Planungswerkzeuge stoßen bei diesen Echtzeitanpassungen oft an ihre Grenzen.

Reinforcement Learning für die Wiederbeschaffung

Die Wiederbeschaffung ist eine zentrale Funktion im Supply Chain Management – sie bestimmt, wann und wie viel Bestand nachbestellt werden muss, um die Verfügbarkeit zu sichern und gleichzeitig die Kosten zu minimieren. Traditionell basiert die Wiederbeschaffung auf prognosegestützten Modellen und vordefinierten Bestandsrichtlinien, wie:

- Economic Order Quantity (EOQ): Geht von einer stabilen Nachfrage und festen Bestellkosten aus.

- (s, S)-Bestandsrichtlinien: Bestellt Lagerbestände nach, wenn ein Schwellenwert unterschritten wird, passt sich jedoch nicht dynamisch an.

- Nachfrageprognosemodelle: Sagen zukünftige Verkäufe mithilfe statistischer Techniken voraus.

Einschränkungen traditioneller Wiederbeschaffungsmodelle

- Starre Annahmen – Viele Modelle setzen eine stabile Nachfrage und feste Lieferzeiten voraus, was in der Realität selten zutrifft.

- Geringe Anpassungsfähigkeit – Traditionelle Modelle reagieren nicht dynamisch auf Lieferverzögerungen, Nachfragespitzen oder saisonale Trends.

- Übersimplifizierung – Wichtige Faktoren wie Lieferantenzuverlässigkeit, Echtzeit-Logistikkosten oder mehrere Lieferkettenebenen werden oft nicht berücksichtigt.

Wann RL in der Wiederbeschaffung einen Vorteil bietet

- Echtzeit-Anpassung – RL-Systeme passen sich dynamisch an Live-Daten an, anstatt auf vordefinierte Regeln zu vertrauen.

- Selbstoptimierende Entscheidungen – RL verfeinert seine Strategie kontinuierlich und verbessert sich im Laufe der Zeit, anstatt statischen Richtlinien zu folgen.

- Multi-Objective-Optimierung – RL optimiert gleichzeitig Kosten, Verfügbarkeit und Resilienz, während traditionelle Modelle meist nur ein einzelnes Ziel fokussieren.

- Bessere Bewältigung von Unsicherheiten – RL kann effektiver auf Nachfrageschwankungen, Lieferengpässe und Kostenveränderungen reagieren als regelbasierte Methoden.

Ein Beispiel: Erkennt ein RL-basiertes Wiederbeschaffungssystem, dass die Lieferzeiten eines Lieferanten zunehmend unzuverlässig werden, kann es proaktiv die Bestellzeitpunkte anpassen oder auf einen alternativen Lieferanten umschwenken – und so Risiken reduzieren, ohne dass manuelle Eingriffe erforderlich sind.

Warum RL traditionelle Wiederbeschaffungsmodelle nicht vollständig ersetzen kann

Trotz dieser Vorteile hat RL auch einige Einschränkungen:

- Hohe Rechenkomplexität – RL benötigt große Datenmengen und erhebliche Rechenleistung, was die Implementierung kostspielig machen kann.

- Lange Trainingszeit – Im Gegensatz zu traditionellen Modellen muss RL erst aus Erfahrungen lernen, bevor es optimale Ergebnisse erzielt.

- Geringe Interpretierbarkeit – RL-Entscheidungen sind oft weniger transparent als regelbasierte Methoden, was ihre Nachvollziehbarkeit in manchen Geschäftsumfeldern erschwert.

Aufgrund dieser Faktoren würden viele Unternehmen von einem hybriden Ansatz profitieren, der traditionelle Prognosemodelle mit RL-basierten Anpassungen kombiniert, um höhere Genauigkeit und Anpassungsfähigkeit zu erreichen.

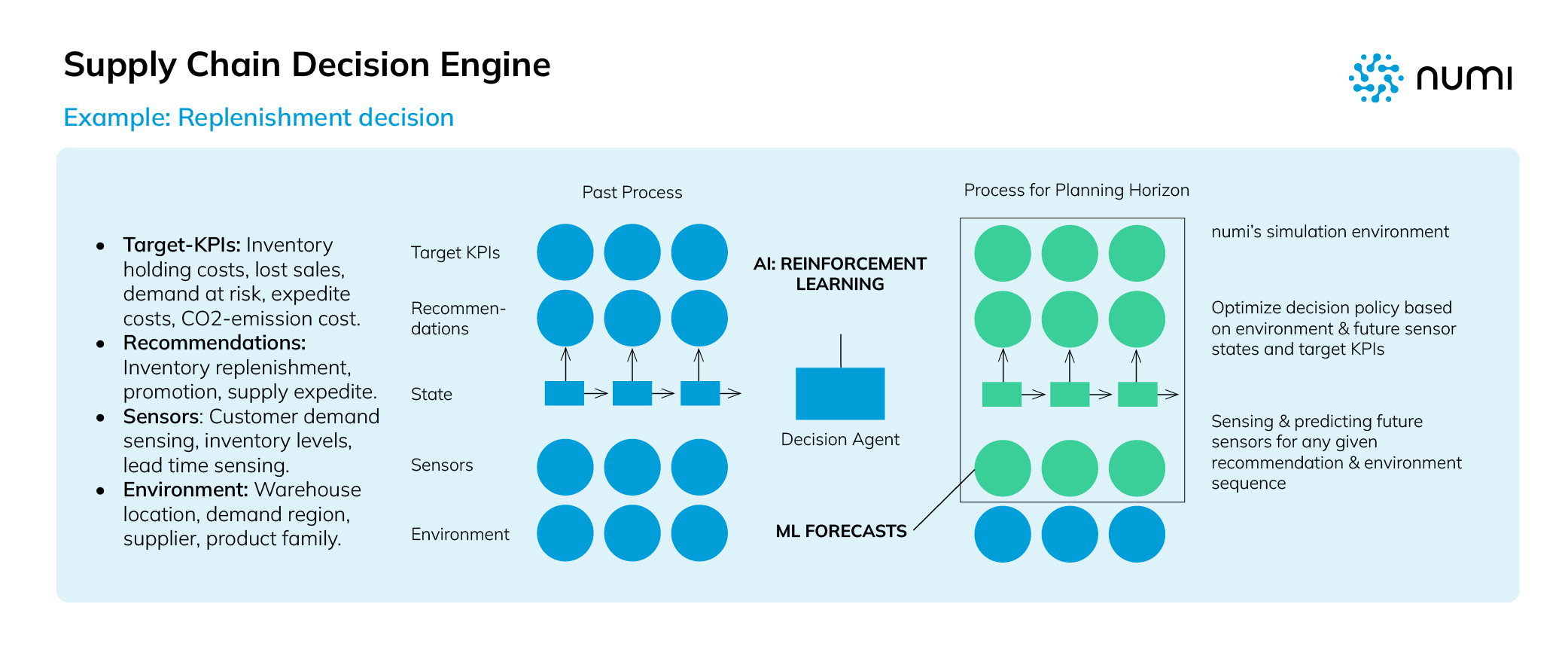

Wie numi Reinforcement Learning integriert hat

Marktbedingungen anzupassen. Um bestehende Ansätze zu ergänzen, haben wir Reinforcement Learning in unsere Supply-Chain-Software integriert. Dadurch können Unternehmen ihre Entscheidungsfindung mit höherer Anpassungsfähigkeit optimieren. Anstatt traditionelle Modelle vollständig zu ersetzen, dient RL als alternatives Entscheidungswerkzeug, das insbesondere in Umgebungen mit schwankender Nachfrage, variabler Lieferantenzuverlässigkeit oder häufigen externen Störungen von Vorteil ist.

Herausforderungen bei der Systemgestaltung

Eine der größten Herausforderungen bei der Implementierung von Reinforcement Learning für die Wiederbeschaffung war die Entwicklung eines effektiven Belohnungssystems. Anders als in Spielen oder der Robotik, wo Belohnungen klar definiert sind (z. B. ein Gewinn oder das Abschließen einer Aufgabe), erfordert die Optimierung der Lieferkette das Ausbalancieren mehrerer, teils widersprüchlicher Ziele.

- Service Level als zentrale Belohnungsmetrik – Unser RL-Modell wurde so konzipiert, dass es die Verfügbarkeit priorisiert, um Nachfrage ohne Lieferengpässe zu erfüllen.

- Kostensenkung als weiteres Ziel – Gleichzeitig war es notwendig, Kosten zu minimieren, insbesondere Lagerhaltungskosten und Überbestände.

- Kurzfristige Einsparungen vs. langfristige Effizienz – Die richtige Balance zwischen sofortigen Kostenvorteilen und einer nachhaltigen Optimierung der Lieferkette erforderte umfangreiche Experimente und Feinabstimmungen.

Zentrale Implementierungsschritte des Wiederbeschaffungssystems

1. Datensammlung und Vorverarbeitung

- Aggregation historischer Verkaufsdaten, Lieferzeiten von Lieferanten, Nachfrageschwankungen und logistischer Einschränkungen.

- Integration von Echtzeit-Daten aus ERP-Systemen, Lagerverwaltung und Supply-Chain-Tracking-Tools.

2. Simulation und Modelltraining

- Einsatz fortschrittlicher Simulationsalgorithmen zur Nachbildung realer Lieferketten-Dynamiken.

- Das Modell lernte durch Interaktion mit verschiedenen Nachfragemustern, Lieferantenverhalten und unerwarteten Störungen.

3. Bereitstellung und kontinuierliches Lernen

- Implementierung des trainierten RL-Modells in realen Lieferkettenumgebungen.

- Ermöglichung eines kontinuierlichen Lernprozesses, sodass das System seine Entscheidungen mit sich ändernden Marktbedingungen weiter optimiert.

Die Zukunft der Wiederbeschaffung ist adaptiv

In einer Zeit, in der Lieferketten ständig von Störungen betroffen sind, kann die ausschließliche Nutzung traditioneller Wiederbeschaffungsmodelle Unternehmen anfällig für Ineffizienzen, Lieferengpässe und hohe Kosten machen. Reinforcement Learning bietet eine leistungsstarke Alternative, indem es Echtzeit-Anpassungsfähigkeit, selbstoptimierende Entscheidungsfindung und dynamische Reaktionen auf Marktveränderungen ermöglicht.

Bei numi haben wir RL erfolgreich in unsere Supply-Chain-Software integriert, sodass Unternehmen ihre Service-Level, Kosten und Resilienz mit einem intelligenteren, datengetriebenen Ansatz ausbalancieren können. RL ist zwar kein vollständiger Ersatz für traditionelle Modelle, aber es ist ein entscheidendes Werkzeug für Unternehmen, die ihre Lieferketten in volatilen Umgebungen zukunftssicher machen wollen.

Die Frage ist: Sind Sie bereit für die nächste Generation der Supply-Chain-Intelligenz? Ob Sie Lieferengpässe reduzieren, Bestände optimieren oder die Agilität Ihrer Lieferkette steigern möchten – RL-basierte Wiederbeschaffung könnte der entscheidende Vorteil für Ihr Unternehmen sein.